Lästid: 6 minuter

Senast redigerad:

Kan sociala robotar hjälpa oss rekrytera mer fördomsfritt?

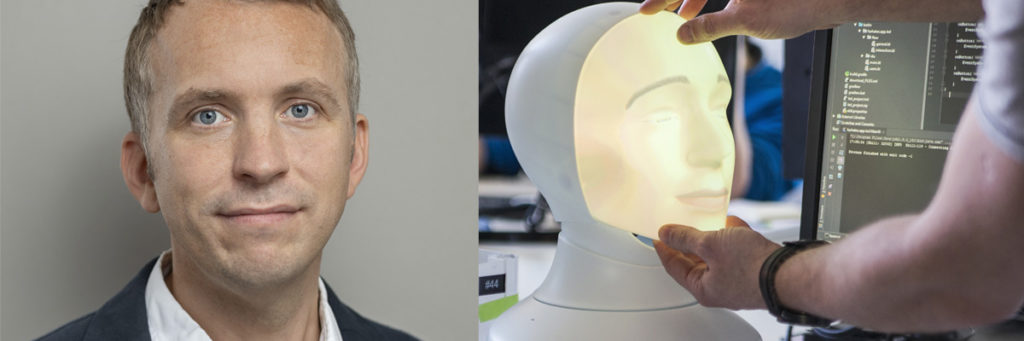

Tengais chefsforskare om resan mot en rekryteringsprocess fri från fördomar

Omedvetna fördomar påverkar allt vi gör och varje beslut vi fattar. Inte minst när det kommer till rekrytering och bemanning. Att utveckla en produkt som Tengai, vars syfte är att objektivt bedöma kandidaters prestation, är därmed minst sagt en utmaning. Så hur gör vi? Här berättar Tengais chefsforskare Gabriel Skantze om Furhat Robotics och TNG:s gemensamma resa mot att skapa en rekryteringsprocess fri från fördomar, och hur vi kan undvika att mänskliga svagheter färgar av sig i robotens algoritmer.

Rekrytering hör till en av de viktigaste delarna av ett företagets verksamhet, och att hitta rätt person för rätt jobb är i många fall avgörande för företagets framgång. Trots detta råder fortfarande stor osäkerhet kring rekryteringsprocessen och anställningsbeslut bygger oftare på magkänsla och subjektiva tolkningar än på rationella resonemang.

Men att skapa en mer objektiv och fördomsfri rekryteringsprocess är förstås inte bara en angelägen fråga för företag. Det handlar också om att göra processen mer rättvis för alla de kandidater som drabbas av fördomarna, och som på grund av dem kanske går miste om ett drömjobb.

Att handskas med fördomar är dock en stor utmaning. Dels för att vår kunskap i frågan är så pass begränsad, och dels för att de signaler som vi grundar våra beslut på kan vara högst subtila.

Intervjuar som en människa

Gabriel Skantze, Professor KTH/forskningschef Furhat Robotics

När man pratar om fördomar tänker de flesta kanske främst på kön och etnicitet. Men det finns också andra, mindre uppenbara faktorer, som längd, vikt och ålder. Och hur mycket vi än pratar om fördomar och försöker medvetandegöra dem så är det mycket svårt att kontrollera de omedvetna, och ofta mycket subtila processer, som styr vårt beteende. Sådant påverkar inte bara vår bedömning av kandidaten, utan även hur samtalen under intervjuerna förs. Vilket i sin tur påverkar kandidatens beteende och därmed rekryteraren eller chefens uppfattning om dem.

Tillsammans med TNG utvecklar vi på Furhat Robotics nu världens första sociala robot framtagen i syfte att adressera dessa problem – Tengai Unbiased. Tengai kommer att hjälpa rekryterare att genomföra intervjuer med kandidater för att bedöma deras färdigheter och kompetenser, utifrån den aktuella rollens kravprofil.

Tanken är att roboten ska genomföra intervjun på ett sätt som i hög grad liknar hur en mänsklig rekryterare skulle göra det. Den kommer använda sig av kompetensbaserade frågor, till exempel: ”Berätta om en arbetssituation då du upplevt det svårt att samarbeta med kollegor i ett team eller projekt. Hur kom det sig att det var svårt?”. Under intervjun kommer den fortlöpande att ge återkoppling – som nickar, leenden och hummanden – för att uppmuntra kandidaten att ge utförliga svar. Om svaret är för vagt kan roboten be kandidaten att ge mer konkreta exempel. Efter intervjun kommer roboten att göra en sammanfattning av intervjun och några objektiva rekommendationer som hjälper de mänskliga rekryterarna att fatta ett beslut om kandidaten.

Så tränar vi robotens beteende

De konversationsfärdigheter vi just nu utvecklar för Tengai är av en mycket mer öppen och komplex natur än till exempel den dialog du har med din smartphone eller smarta högtalare, där du ger systemet korta kommandon eller frågor.

”För att lyckas med detta behöver vi därför utveckla nya algoritmer och driva forskningen inom konverserande system framåt, bland annat med hjälp av maskininlärning.”

Det innebär att vi samlar in data från intervjuer som utförs av människor, där risken för subjektiva tolkningar minimerats så mycket som möjligt, och sedan tränar systemet för att återspegla den mänskliga rekryterarens beteende under intervjun.

För datainsamlingen använder vi en metod som kallas ”Wizard-of-Oz”, efter filmen från 1939 där det avslöjades att den mystiske trollkarlen egentligen inte existerade utan i stället kontrollerades av en man gömd bakom ett draperi. På motsvarande sätt har vi i början av projektet låtit Tengai styras av en mänsklig rekryterare som suttit i ett annat rum och kontrollerat robotens beteende, vilket gjort det möjligt för oss att spela in data. Dessa data kommer nu att användas för att utveckla två olika modeller: En som kan efterlikna rekryterarens beteende under intervjun och en som kan göra bedömningen av kandidaterna efter intervjuerna.

Så ser vi till att Tengai förblir objektiv

Tengai Unbiased – by TNG and Furhat Robotics

Så för att återgå till den ursprungliga frågan: Hur kan en robot av det här slaget bidra till att skapa en mer objektiv och fördomsfri rekryteringsprocess? Finns det inte risk att våra egna fördomar överförs till de robotar som vi tränar på? Detta är en fråga som har flera svar.

Lås oss börja med automatiseringen av intervjun. Här kommer roboten ha ett mycket mer konsekvent beteende gentemot kandidaten än vad en mänsklig rekryterare har. Detta eftersom vi enkelt kan se till att den inte använder exempelvis ett visst tonläge eller ser skeptisk ut mot vissa kandidater (något som är omöjligt att få en mänsklig rekryterare att göra). Visst kan de rekryterare som under testfasen styr intervjuerna potentiellt påverkas av faktorer som ålder, kön och etnicitet i sättet de trycker på knapparna för att styra roboten.

”Här kan vi dock se till att dessa faktorer inte kommer vara tillgängliga för det automatiserade system som vi tränar, vilket innebär att dessa faktorer i slutändan inte kommer kunna påverka robotens beteende.”

Som ett (hypotetiskt) exempel kan vi tänka oss en rekryterare som konsekvent avbryter kvinnliga kandidater mer än manliga. Om information om kandidatens kön inte skulle vara tillgängligt för roboten skulle den helt enkelt ”misslyckas” med att imitera detta beteende. Den skulle endast kunna lära sig att den ska avbryta vissa gånger och ibland inte – men beslutet skulle inte vara baserat på kandidatens kön. Detta argument är giltigt åtminstone så länge vi talar om direkt tillgång till dessa faktorer. Men det är viktigt att också vara medveten om att systemet kan ha indirekt tillgång till sådana faktorer.

För att fortsätta med samma exempel: om systemet har tillgång till kandidatens röst, skulle det potentiellt kunna associera en hög grundton i rösten (vilket är vanligare bland kvinnor) med att den ska avbryta oftare. Även om detta förhållande är mycket mer indirekt så är det fortfarande oönskat. Därför är det väldigt viktigt att vi förstår varför systemet fattar sina beslut.

Lyckligtvis finns det ett antal sätt att undersöka de modeller som vi har tränat för att förstå vilka faktorer som används för att fatta vilka beslut, för att säkerställa att de är objektiva. Detta brukar man benämna Explainable AI, något som nyligen väckt stort intresse inom forskningen kring maskininlärning. Det är verkligen en utmanande uppgift, men att analysera och förstå potentiella fördomar hos en AI är förmodligen mer genomförbart än att öppna upp hjärnan och analysera fördomar hos en mänsklig chef eller rekryterare.

Att automatisera bedömning av kandidater

När det kommer till att automatisera bedömningen av kandidaterna är det återigen viktigt att de data vi tränar våra modeller på är så fördomsfria som möjligt, samt att bedömningen görs med hjälp av ett verifierat kompetensramverk från en tredje part.

Dessutom kommer vi ta hjälp av ett flertal erfarna rekryterare som också är utbildade inom diskrimineringslagstiftningen. Dessa rekryterare har arbetat med en objektiv rekryteringsprocess i många år och väl införstådda med de olika dimensionerna av omedvetna fördomar.

”Flera rekryterare kommer att bedöma samma inspelade intervjuer oberoende av varandra, vilket innebär att vi kommer att kunna träna våra modeller på deras samlade bedömning.”

I den här processen kommer vi se till att de som utför bedömningarna inte är samma rekryterare som genomförde intervjuerna. Dessutom kommer de bara ha tillgång till råtranskriptionerna av intervjuerna, och inte till ljud- eller videodata. Det innebär att de inte kommer kunna basera sina beslut på någon av de mest uppenbara subjektiva faktorerna – såsom kön, etnicitet, utseende och ålder.

Men även om vi reducerar mänskliga fördomar så mycket som möjligt i processen ska man vara medveten om att det även finns en potentiell risk att vi inför ”fördomar” via de algoritmer som vi använder – så kallad ”algoritmisk bias”. Till exempel kan det finnas risk att taligenkänningen (som översätter tal till ord) kan fungera sämre för kandidater med utländsk brytning eller särskilt kön. Detta skulle eventuellt kunna påverka resultatet av intervjun.

För att minska risken för detta kommer vi att genomföra noggranna analyser av hur dessa komponenter fungerar på den data som vi har spelat in, för att se om vissa grupper påverkas. Man bör dock vara försiktig med att dra alltför förhastade slutsatser, eftersom det inte är säkert att en något sämre prestanda i de tidiga faserna av processen kommer påverka det slutgiltiga resultatet när det gäller robotens beteende och analys av intervjuerna. I många fall kan det finnas sätt att kompensera för dessa brister.

Mot en mer fördomsfri rekryteringsprocess

Sammanfattningsvis kan vi konstatera att det inte finns någon mirakelkur mot fördomar. Att helt avlägsna fördomar, från såväl rekryteringsprocesser som andra aspekter av våra liv, kommer kanske aldrig vara möjligt.

Däremot tror vi att en robot kan tillföra en högre grad av öppenhet, transparens och konsekvens i rekryteringsprocessen. Till skillnad från en mänsklig rekryterare kan vi kontrollera robotens beteende i detalj – ner till mikrorörelser i mungipan. Och till skillnad från en mänsklig rekryterare har vi mycket bättre verktyg för att analysera och förstå motiven bakom dess beslut. Detta gör i sin tur att vi kan undvika att upprepa mänskliga beteenden baserade på fördomar som är vanliga vid rekrytering idag. Vi anser därför att utvecklingen av Tengai för oss ett steg närmare en mer fördomsfri rekryteringsprocess.

Skribent: Gabriel Skantze, Professor KTH/forskningschef Furhat Robotics